訂閱電子報,掌握最新科技與產業趨勢

2021/05/05

NVIDIA GTC - 深度學習機構 DLI 實作坊體驗心得

NVIDIA一年一度的巡迴技術盛會GTC照常於4月舉辦,今年盛會期間有三場中文「實作訓練/實作坊」可報名參加,為每天一主題的白天全天(8小時)遠端線上即時課,分別為深度學習基礎理論與實踐(DLIW2471)、多GPU深度學習基本原理(DLIW2472)以及運用於智慧影片分析的深度學習技術(DLIW2473)。

筆者報名了第一天的深度學習基礎理論與實踐(DLIW2471),由NVIDIA資深解決方案架構師李正匡博士主講。

李博士一開始說明AI技術的發展歷程,其實早於1950年代人們即從生物學上得到靈感而嘗試開發神經網路型電腦,但發展不及馮曼紐架構的電腦快速而停滯;之後人們也嘗試發展專家系統,也因需大量的工程師、需遵循眾多嚴謹規則而難以開展;直至近年來ML、DL技術的提出,發展方逐漸走向務實。

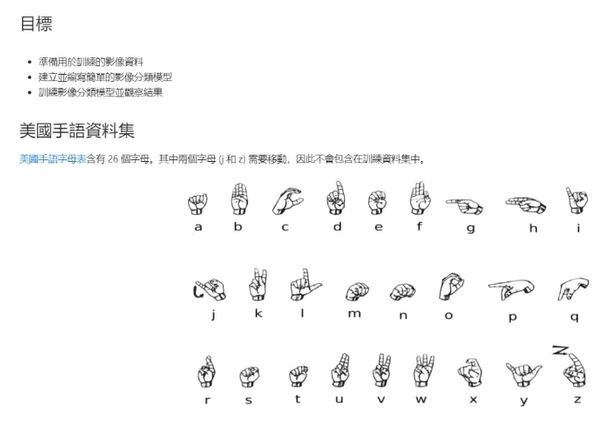

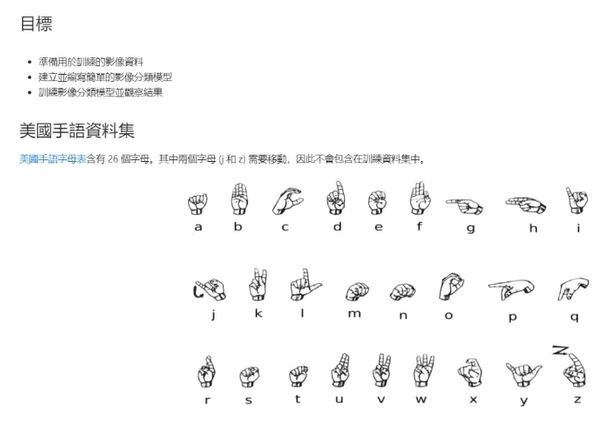

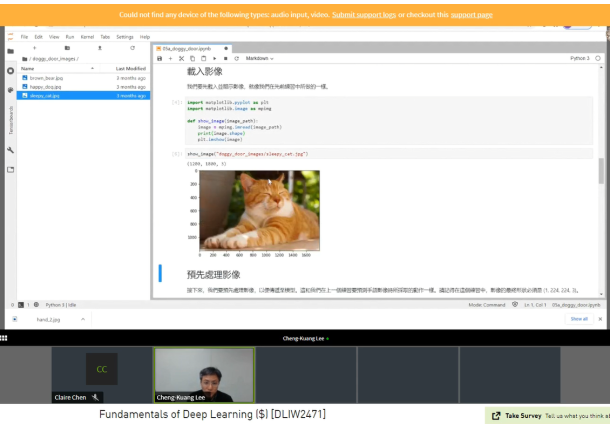

接著進入實務,本次課程使用TensorFlow與Keras,但也建議學員課後能摸索其他的平台,如Facebook力主的PyTorch或Microsoft的MXNet。實務學習從基礎的手寫數字(0~9)影像辨識開始,並使用MNIST資料集,之類也練習美式手語的英文字母辨識。

線上即時課的好處是示範具有說服力,過程中有狀況也能求助並即時排除,例如MNIST資料集連結失效,講師可立即關注、協助、提供排除建議等。

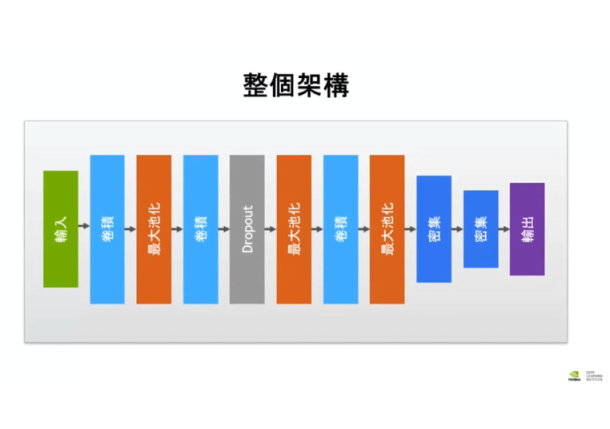

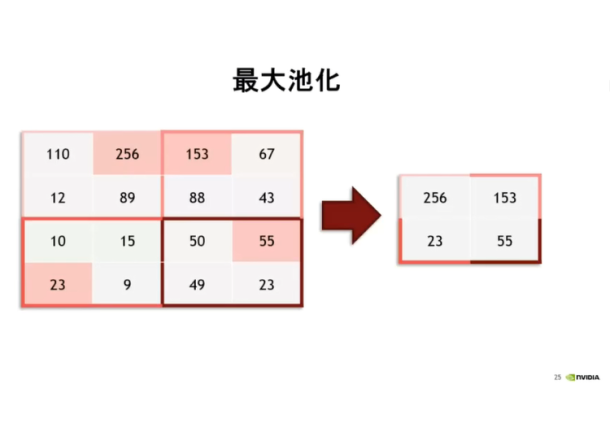

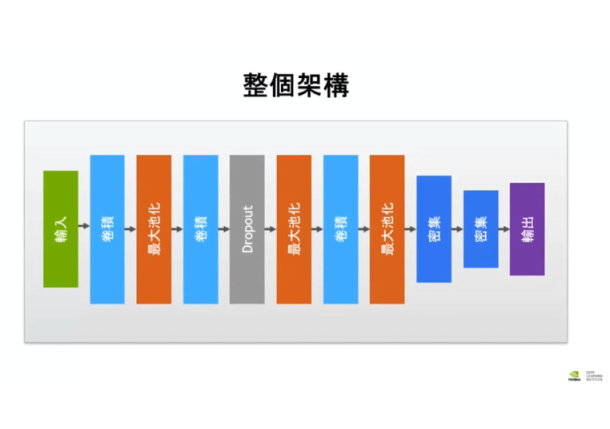

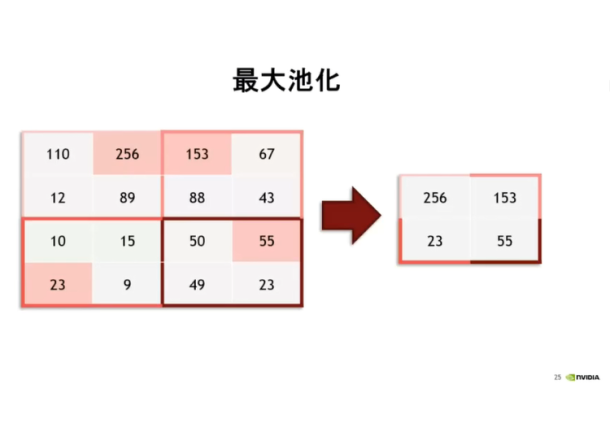

在讓學員親手打造神經網路前李博士也解釋神經網路的結構,包含輸入層、隱藏層、輸出層、激勵函數(activation function)等,另外也說明各層的機理用意,例如最大池化(MAX Pooling)的程序是為了降低資料量,並有助於之後逐漸擴大辨識輪廓,一開始看到貓耳,而後是貓臉,最後是貓全身等。

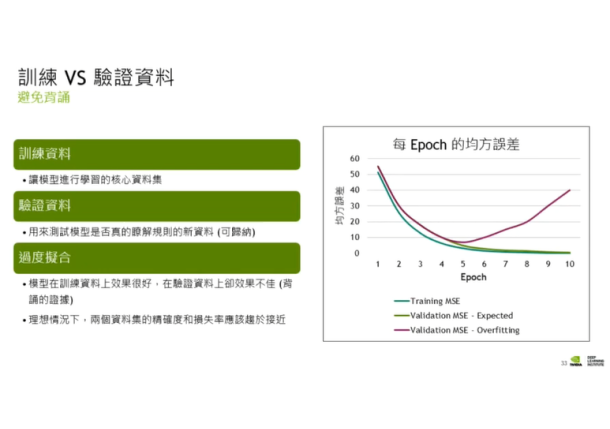

過程中學員詢問(透過room chat)該選擇怎樣的網路模型?李博士也解答:目前確實有人在研究當如何選擇最佳的模型,屬於另一個大領域;另也解答為何訓練的辨識率為何會略高於驗證的辨識率。

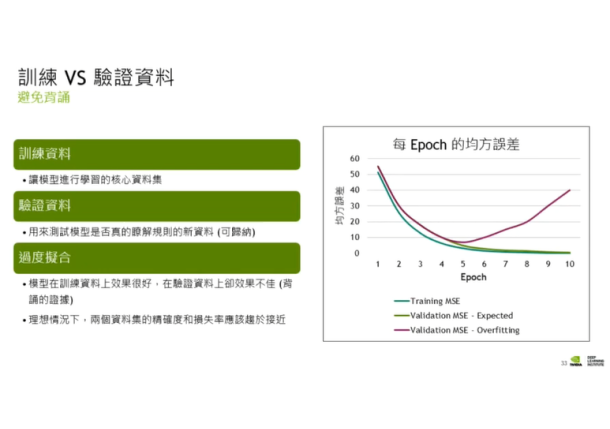

此外,為了避免訓練出來的模型過度擬合(overfitting,或稱過度學習)李博士也列舉一些方法,一是在訓練均方誤差與驗證均方誤差(Mean-Square Error, MSE)的曲線開始偏離時停止訓練,另一是刻意隨機讓20~40%的節點失效,稱為Dropout。

類似的,實務上還有其他問題要解決,例如訓練資料不足時該如何持續精進模型的辨識率?這時可以用上「資料增強,Data Augmentation」技術,李博士提醒使用資料增強時所應注意的事項,訓練用的圖片雖可變化,但不可違背模型訓練的任務原意。

類似的,實務上還有其他問題要解決,例如訓練資料不足時該如何持續精進模型的辨識率?這時可以用上「資料增強,Data Augmentation」技術,李博士提醒使用資料增強時所應注意的事項,訓練用的圖片雖可變化,但不可違背模型訓練的任務原意。

舉例而言,如果是要訓練一個能辨識出圖片中彈珠的模型,則增強的圖片可以將彈珠平移、可以將圖片變色等,但不可以把圖中的彈珠變不見,如此就屬於不合理的增強。又或者是要訓練一個能辨識左手、右手的模型,這時就不能把左手的照片作鏡像翻轉來當成訓練素材。

在模型訓練驗證完成後即進入部署階段,過程中學員問及Triton部署,李博士回覆Triton部署已屬進階領域,未在入門範疇中。

最後,也由於李博士是業師(業界講師),相較於學術型講師有更多的業界實務可供分享,例如可以到TensorFlow Hub網站去下載別人已經預先訓練好的模型來修改,省去自己從無到有建立模型;或者,課程中用到的範例畢竟較理想,如果想真的累積實務經驗,建議可以多去參加資料科學競賽平台Kaggle上的比賽。

而關於資料類型的運用李博士也舉例,一維性的資料如有時間序列性的股價,可用來分析歷史性的股價上下波動曲線從而預測後續的可能變化;二維性的則有本次課程中的平面影像辨識;三維性的則如醫療領四的胸腔掃描影像。

在上完課程後,除了能在申請的註冊帳號內獲得學習證書外,課程中的相關講義及範例程式等也會持留一段時間,供學員複習。

筆者報名了第一天的深度學習基礎理論與實踐(DLIW2471),由NVIDIA資深解決方案架構師李正匡博士主講。

李博士一開始說明AI技術的發展歷程,其實早於1950年代人們即從生物學上得到靈感而嘗試開發神經網路型電腦,但發展不及馮曼紐架構的電腦快速而停滯;之後人們也嘗試發展專家系統,也因需大量的工程師、需遵循眾多嚴謹規則而難以開展;直至近年來ML、DL技術的提出,發展方逐漸走向務實。

接著進入實務,本次課程使用TensorFlow與Keras,但也建議學員課後能摸索其他的平台,如Facebook力主的PyTorch或Microsoft的MXNet。實務學習從基礎的手寫數字(0~9)影像辨識開始,並使用MNIST資料集,之類也練習美式手語的英文字母辨識。

線上即時課的好處是示範具有說服力,過程中有狀況也能求助並即時排除,例如MNIST資料集連結失效,講師可立即關注、協助、提供排除建議等。

在讓學員親手打造神經網路前李博士也解釋神經網路的結構,包含輸入層、隱藏層、輸出層、激勵函數(activation function)等,另外也說明各層的機理用意,例如最大池化(MAX Pooling)的程序是為了降低資料量,並有助於之後逐漸擴大辨識輪廓,一開始看到貓耳,而後是貓臉,最後是貓全身等。

過程中學員詢問(透過room chat)該選擇怎樣的網路模型?李博士也解答:目前確實有人在研究當如何選擇最佳的模型,屬於另一個大領域;另也解答為何訓練的辨識率為何會略高於驗證的辨識率。

此外,為了避免訓練出來的模型過度擬合(overfitting,或稱過度學習)李博士也列舉一些方法,一是在訓練均方誤差與驗證均方誤差(Mean-Square Error, MSE)的曲線開始偏離時停止訓練,另一是刻意隨機讓20~40%的節點失效,稱為Dropout。

類似的,實務上還有其他問題要解決,例如訓練資料不足時該如何持續精進模型的辨識率?這時可以用上「資料增強,Data Augmentation」技術,李博士提醒使用資料增強時所應注意的事項,訓練用的圖片雖可變化,但不可違背模型訓練的任務原意。

類似的,實務上還有其他問題要解決,例如訓練資料不足時該如何持續精進模型的辨識率?這時可以用上「資料增強,Data Augmentation」技術,李博士提醒使用資料增強時所應注意的事項,訓練用的圖片雖可變化,但不可違背模型訓練的任務原意。舉例而言,如果是要訓練一個能辨識出圖片中彈珠的模型,則增強的圖片可以將彈珠平移、可以將圖片變色等,但不可以把圖中的彈珠變不見,如此就屬於不合理的增強。又或者是要訓練一個能辨識左手、右手的模型,這時就不能把左手的照片作鏡像翻轉來當成訓練素材。

在模型訓練驗證完成後即進入部署階段,過程中學員問及Triton部署,李博士回覆Triton部署已屬進階領域,未在入門範疇中。

最後,也由於李博士是業師(業界講師),相較於學術型講師有更多的業界實務可供分享,例如可以到TensorFlow Hub網站去下載別人已經預先訓練好的模型來修改,省去自己從無到有建立模型;或者,課程中用到的範例畢竟較理想,如果想真的累積實務經驗,建議可以多去參加資料科學競賽平台Kaggle上的比賽。

而關於資料類型的運用李博士也舉例,一維性的資料如有時間序列性的股價,可用來分析歷史性的股價上下波動曲線從而預測後續的可能變化;二維性的則有本次課程中的平面影像辨識;三維性的則如醫療領四的胸腔掃描影像。

在上完課程後,除了能在申請的註冊帳號內獲得學習證書外,課程中的相關講義及範例程式等也會持留一段時間,供學員複習。